La mayoría de nosotros hemos jugado con la función de intercambio de caras de Snapchat al menos una vez. Incluso puede descargar aplicaciones para mejorar su creación de memes

Sin embargo, puede preguntarse, ¿Qué tienen que ver estas nuevas herramientas con la ciberseguridad ? La respuesta está en su desempeño en el progreso tecnológico. Hace unos diez años, solamente los estudios de cine y un verdadero psicópata tenían la capacidad de producir fascinantes videos compuestos ( deepfake ). Ahora, con un conocimiento de codificación convencional y alguno que otro software de código abierto, cualquiera hijo de vecino puede crear videos falsos muy convincentes

- Cybersecurity Capstone: Breach Response Case Studies

- Terrorism Financing

- Cyber Threat Intelligence

- MITRE ATT&CK.

- Calibre, lectura y aprendizaje.

Entonces, ¿estaremos en condiciones de distinguir una falsificación de un video genuino?? Aquí tenemos una pequeña prueba de Microsoft lo cual seria un muy buen punto de de partida.

En los siguientes párrafos basados en el trabajo de House, N. (2021, 2 septiembre)[10], haremos una acotada pero profunda inmersión sobre en el deepfake y el porqué puede ser un real problema para los profesionales de la ciberseguridad.

¿Cómo se crean los videos deepfake ??

- Según INCIBE (2021), los deepfakes [1] son videos que han sido manipulados para convencer a los usuarios que los ven de que alguien, ya sea anónimo o público, ha hecho una declaración o un comportamiento que nunca ha sucedido. Para la creación de estos videos se utilizan herramientas o programas equipados con tecnología de inteligencia artificial, que permiten el intercambio de rostros en imágenes y la modificación de voces.

- Deepfakes son parte de una categoría de IA llamada «Redes de adverso generativas» o GAN , en la que dos redes neuronales compiten para crear fotografías o videos que parecen reales. Las GAN consisten en un generador, que crea un nuevo conjunto de datos como un video falso, y un discriminador, que utiliza un algoritmo ML para sintetizar y comparar datos del video real. El generador sigue intentando sintetizar el video falso con el anterior hasta que el discriminador no pueda decir que los datos son nuevos. [2]

- De forma incremental la red generativa mejora en la creación de contenido. De igual manera, la red discriminatoria mejora su capacidad para identificar las falsificaciones por lo que cada red aprende de la otra.

- Esta técnica se utiliza como un «entrenamiento» no supervisado para las inteligencias artificiales, el cual se denomina algoritmo RGA. Donde una de las IAs genera contenido tomando como referencia el vídeo base y otro vídeo o fotos de la cara que se quiere superponer, y una segunda va evaluando el resultado hasta que no es capaz de identificarlo como falso. [3]

- Basados en esto, se tiene el potencial necesario para poder crear una transmisión de medios completamente falsa.

Herramientas Deepfake

Aplicaciones

Podemos afirmar que la escasez de aplicaciones para Deepfake descargables listas para usar no será un problema. De hecho aquí hay tenemos un buen listicle con las más populares que actualmente se encuentran disponibles. [4]

Estas aplicaciones son de fácil uso, muchas de ellas son completamente gratuitas. La mayoría casi siempre esta centrado mas que todo en la diversión y no tanto ofrecer resultados realistas.

Software

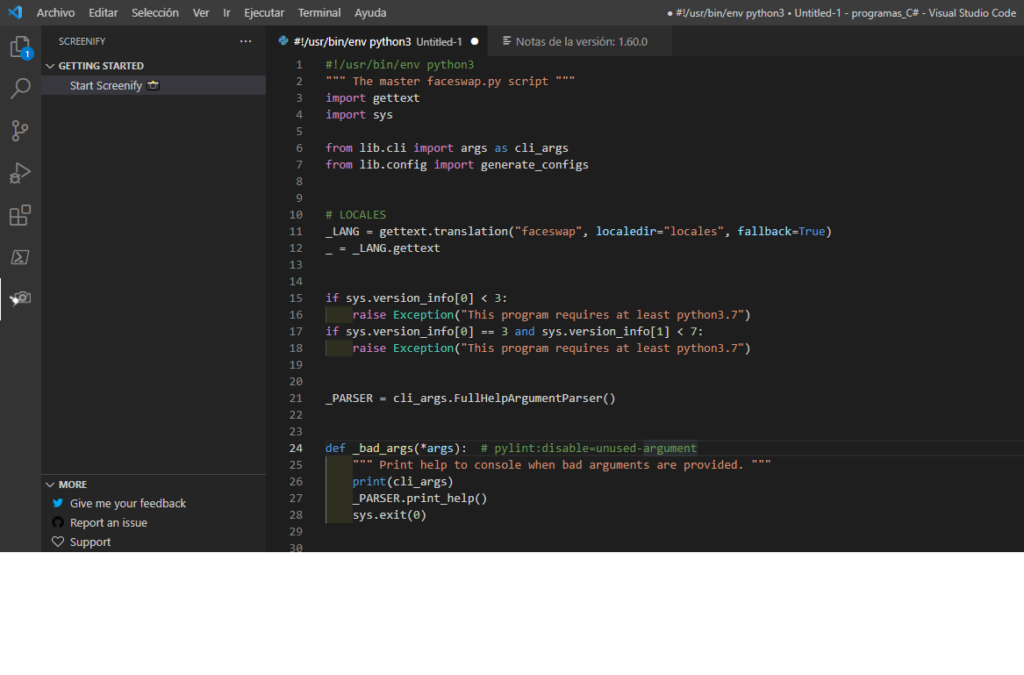

Si su interés es crear su propio deepfake (con fines de investigación), le hará falta algún software dedicado. Para esto, nada mejor que un poco de Python, según lo menciona GitHub – deepfakes/faceswap , no necesita ser un maestro de Python, pero un conocimiento básico, o la capacidad al menos de reconocerlo, le será de gran ayuda. [6]

Será necesaria además, una tarjeta gráfica dedicada o una GPU virtual, se puede hacer una visita corta a Google Cloud.

Las plataformas de software con mayor popularidad incluyen DeepFace Labs y Faceswap.

Cuales son los problemas para los profesionales de la Ciberseguridad

Probablemente haya visto o leído parte de las implicaciones políticas de las deepfake. Los diferentes potenciales escenarios incluyen videos falsos que se envían para desacreditar a diferentes políticos, también esta el apoyar teorías de conspiración y, en su mayoría, el lograr sembrar una desconfianza en los distintos procesos que tienen que ver con la política. [7]

Muy distante a lo anterior, los comunes ciudadanos y las empresas están comenzando a tomar el peso de los riesgos que conlleva la tecnología deepfake. Una reciente encuesta [8] sugiere que el 80% de las empresas se consideran preocupadas por diversos riesgos, pero solamente menos de un tercio han adoptado medidas para prevenirlos. Es definitivamente imperioso que los especialistas en Ciberseguridad tengan en cuenta las implicancias y riesgos que conllevan las deepfake.

Entonces, ¿Cuáles serian estos riesgos??

- Fraude: Un hacker (considerando que sea con fines educativos) podría eventualmente acceder a un fragmento de video con acceso público del CEO en determinada empresa. Utilizando una pila GAN, la que demostramos lo fácil se puede obtener en Github, podría generar un mensaje de video corto grabado y enviarlo directamente por razones de suma urgencia, ya sea por correo electrónico, o cualquier plataforma interna a su jefe de cuentas, donde le solicite liberar fondos a una determinada cuenta, lo que daría tiempo y confianza necesaria antes de verificar los requerimientos del CEO.

- Reputación: un hacker inventa una transmisión, como si fueran imágenes secretas de su jefe desviando fondos de su empresa o expresando declaraciones perjudiciales para la organización.

De los anteriores riesgos, el fraude es probablemente uno de los incidentes más directo para proteger. La organización puede asegurar sus comunicaciones internas y externas con sistemas estándar certificados y complementar cualquier solicitud de video, ya sea para una divulgación de información o solicitud de fondos, siempre respaldándose en una firma electrónica comprobable, o incluso una simple solicitud por escrito, ya sea por correo o documento electrónico, exigiendo así su autenticación.

El poder comprobar que un video es falso en el caso de perdida de la reputación, será por decirlo menos un gran desafío. Lo mejor seria contactar a un especialista en gestión de crisis corporativo y en paralelo contratar un experto en video forense especializado en autenticación.

Así como Mary Branscombe en TechRepublic [9] escribio su articulo dando el énfasis a que todo el esfuerzo de análisis debe estar en la procedencia. Dicho de otra forma, el contenido de video debe quedar y dejarse absolutamente en la claridad de metadatos verificables, el dónde y cuándo fue producido, quién lo generó, así también el cómo fue editado. Un deepfake puede parecer muy real, y si no se esta al nivel de auditabilidad que señala este articulo, difícilmente un ojo normal (con suerte) lo verán.

Bibliografía

- Instituto Nacional de Ciberseguridad. (2021, 3 junio). Deepfakes: las apariencias engañan. INCIBE. https://www.incibe.es/aprendeciberseguridad/deepfakes

- Horowitz, Brian T. (13 de mayo de 2019). «AI and Machine Learning Exploit, Deepfakes, Now Harder to Detect Deepfake videos are enabled by machine learning and data analytics». PC Magazine.

- D. (2020, 12 marzo). deep-fake.es – ¿Qué son los deepfake? web.archive.org. https://web.archive.org/web/20200813080601/https://deep-fake.es/index.php/2019/12/19/deepfake/

- Staff, B. (2021, 29 junio). 10 Best Deepfake Apps and Websites You Can Try for Fun. Beebom. https://beebom.com/best-deepfake-apps-websites/

- Top 6 Python Deepfake Projects. (s. f.). Libhunt.Com. Recuperado 5 de septiembre de 2021, de https://www.libhunt.com/l/python/t/deepfakes

- D. (s. f.). GitHub – deepfakes/faceswap: Deepfakes Software For All. GitHub. Recuperado 5 de septiembre de 2021, de https://github.com/deepfakes/faceswap

- O’Sullivan, D. C. (2019, 4 junio). Congress to investigate deepfakes as doctored Pelosi video causes stir – CNNPolitics. CNN. https://edition.cnn.com/2019/06/04/politics/house-intelligence-committee-deepfakes-threats-hearing/index.html

- Attestiv Inc. (s. f.). deepfake2021. Download.Attestiv.Com. Recuperado 5 de septiembre de 2021, de https://download.attestiv.com/deepfake2021

- Branscombe, M. (2021, 26 julio). Deepfakes: Microsoft and others in big tech are working to bring authenticity to videos, photos. TechRepublic. https://www.techrepublic.com/article/deepfakes-microsoft-and-others-in-big-tech-are-working-to-bring-authenticity-to-videos-photos/?ftag=TRE684d531&bhid=29403150604662395936266198854611&mid=13451207&cid=2272074152

- House, N. (2021, 2 septiembre). Can you be fooled by a deepfake video? Take this test. . .. Station X. https://www.stationx.net/can-you-be-fooled-by-a-deepfake-video-take-this-test/?utm_source=udemy&utm_medium=post&utm_campaign=deepfake-video&cmc_project=stationx-main&utm_medium=875976&utm_campaign=2021-09-02&utm_term=15858120&utm_content=educational&utm_source=email-sendgrid

- Heras, J. M. (2020, 19 octubre). Redes Neuronales Generativas Adversarias (GANs). IArtificial.net. https://www.iartificial.net/redes-neuronales-generativas-adversarias-gans/

Especialista en seguridad de la información, ciberseguridad, redes y telecomunicaciones militares, serví en la Armada de Chile por un período de 27 años dónde lideré equipos de apoyo a operaciones de inteligencia Naval, En los últimos 07 me he dedicado a formalizar una carrera en Ciberseguridad, profundizando mis competencias en Mitre, SOC, CEH, CCNA Security y todo le que este a mi alcance. Espero que mi pequeño blog ayude de alguna manera a quien quiera aprender.